La comprensión de las especificaciones desempeña un papel esencial en la comprensión y el cumplimiento de los aspectos técnicos de un proyecto. Este proceso implica analizar y entender detalladamente las especificaciones con el objetivo de garantizar que las expectativas del cliente se satisfagan y de que el producto se diseñe de manera apropiada. Además, fomenta la comunicación efectiva entre los equipos y contribuye a la estimación de recursos y costos. Asimismo, desempeña una función clave en el aseguramiento de la calidad, al establecer criterios para la inspección y las pruebas. En resumen, la interpretación de las especificaciones es esencial para la comprensión, la comunicación y el cumplimiento de los requerimientos técnicos, lo que en última instancia asegura el éxito del proyecto.

Es fundamental considerar que ningún dispositivo o producto es completamente impecable, y en todas las mediciones efectuadas inevitablemente existe un nivel de incertidumbre o margen de error. La incertidumbre se relaciona con la falta de conocimiento total sobre el valor verdadero de la magnitud medida. En contraste, el error se vincula con la diferencia entre el valor medido y el valor real. Por otra parte, la exactitud se refiere a qué tan cercano está el valor medido al valor verdadero.

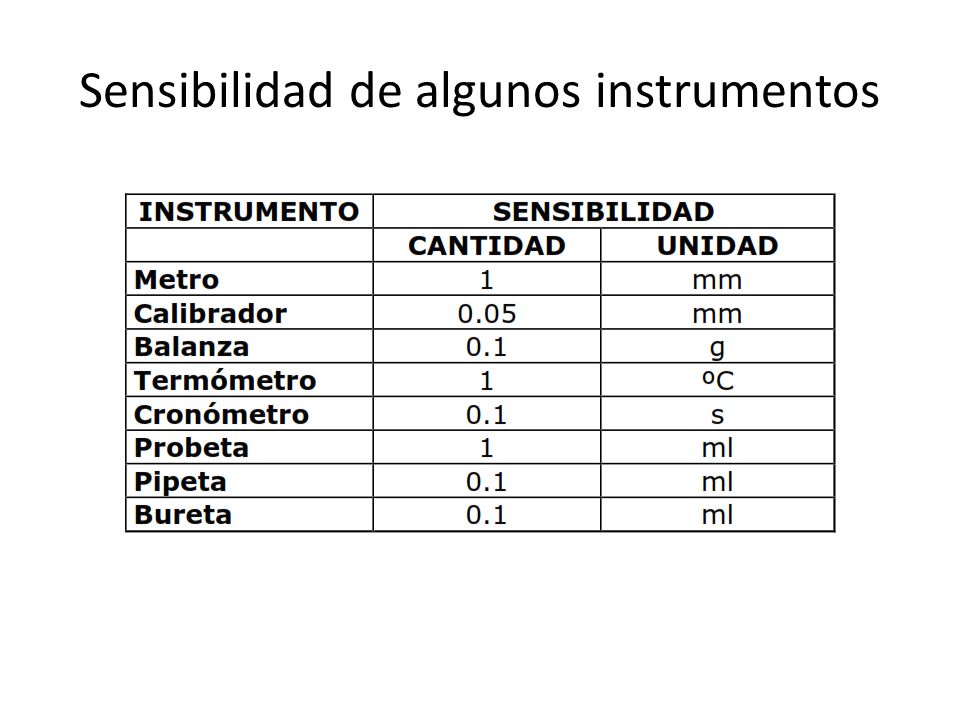

Es por eso que la mayoria de compañias proveen una tabla con sus especificaciones de preisión tal como se puede apreciar a continuacion:

Aunque estos conceptos pueden parecer confusos en un principio y muy similares, si que hay una diferencia entre ellos, por eso trataremos de aclararlo de la mejor manera posible:

Exactitud: La exactitud se refiere a la capacidad de una medición o de un instrumento de medición para proporcionar resultados cercanos o próximos al valor verdadero o al valor de referencia de una magnitud específica. En otras palabras, la exactitud mide cuán precisas son las mediciones en relación con el valor real o esperado. Cuando se habla de exactitud, se considera tanto el error sistemático (sesgo) como el error aleatorio (variabilidad en las mediciones).

Una medición se considera más exacta cuando sus resultados se acercan de manera consistente al valor verdadero o al valor de referencia deseado, y cuando el margen de error es mínimo. La exactitud es un componente esencial en la metrología y la instrumentación, ya que determina la confiabilidad de las mediciones y su utilidad en una variedad de aplicaciones científicas, industriales y tecnológicas.

Sensibilidad: La sensibilidad se refiere a la capacidad de un sensor, instrumento o sistema de medición para detectar y responder a cambios en una magnitud o estímulo particular. En otras palabras, la sensibilidad mide la respuesta del dispositivo ante variaciones en la magnitud que está diseñado para medir.

En el contexto de los sensores, la sensibilidad se expresa como la relación entre la variación en la señal de salida del sensor y la variación correspondiente en la magnitud de entrada. Por ejemplo, un sensor de temperatura sensible será capaz de detectar incluso pequeñas variaciones en la temperatura y producir una respuesta proporcional en su señal de salida.

La sensibilidad determina la capacidad de un dispositivo para percibir y cuantificar cambios en el entorno o en una magnitud específica. Una mayor sensibilidad generalmente se traduce en una capacidad de detección más precisa y fina, lo que puede ser esencial en aplicaciones donde se requiere una medición precisa y una respuesta rápida a cambios en las condiciones.

Resolución: La resolución en un instrumento se refiere a la capacidad de dicho instrumento para distinguir y mostrar con precisión pequeños incrementos o cambios en una magnitud o variable medida. En otras palabras, la resolución indica cuán finamente puede dividir un instrumento una escala de valores dentro del rango de medición.

La resolución se expresa típicamente en términos de la menor unidad de medida que el instrumento puede detectar y mostrar de manera confiable. Por ejemplo, si estás utilizando un termómetro digital con una resolución de 0.1 grados Celsius, esto significa que el instrumento puede mostrar diferencias de temperatura de 0.1 grados Celsius. Si la temperatura cambia en 0.05 grados Celsius, el termómetro no podrá detectar este cambio debido a su resolución limitada.

Es una característica importante ya que determina la capacidad del instrumento para proporcionar mediciones detalladas y precisas, especialmente cuando se trata de pequeños cambios en la magnitud medida. Una resolución más alta generalmente implica una capacidad de medición más precisa y detallada, pero también puede requerir una mayor sensibilidad y precisión en el instrumento.

Comentarios

Publicar un comentario